O GLM 4.7 chega ao mercado como uma resposta direta e poderosa da Zhipu AI às demandas por modelos de linguagem mais competentes em raciocínio complexo e desenvolvimento de software.

Esta nova ferramenta não apenas promete, mas entrega resultados que desafiam gigantes estabelecidos, posicionando-se como uma alternativa viável e, em muitos casos, superior às opções atuais.

Se você busca entender como o GLM 4.7 pode transformar fluxos de trabalho, especialmente em programação e lógica, este artigo detalha cada aspecto dessa inovação.

Menu de navegação

TogglePotencial e inovações do modelo GLM 4.7

A Zhipu AI desenvolveu este sistema com foco em arquitetura de Mistura de Especialistas (MoE), o que permite um processamento mais ágil e direcionado.

Diferente de modelos densos tradicionais, o sistema ativa apenas os parâmetros necessários para cada tarefa, resultando em uma eficiência energética e computacional notável.

Tal característica torna a ferramenta acessível sem sacrificar a profundidade do raciocínio.

Além da arquitetura, a capacidade de retenção de contexto é um diferencial significativo.

Com suporte para janelas de contexto extensas, que podem chegar a 200 mil tokens, o modelo consegue manter a coerência em longas conversas ou na análise de grandes bases de código.

Para desenvolvedores e analistas de dados, tal funcionalidade permite que o assistente compreenda projetos inteiros de uma só vez, oferecendo sugestões que consideram a totalidade do problema, não apenas fragmentos isolados.

Raciocínio intercalado e preservação de pensamento

Uma das funcionalidades mais impressionantes é o mecanismo de “pensar antes de agir”.

O modelo GLM 4.7 utiliza um processo de raciocínio intercalado, onde ele planeja a execução de tarefas complexas antes de gerar a resposta final ou executar um comando.

Esse método reduz drasticamente a taxa de erros em instruções de múltiplas etapas.

Adicionalmente, a tecnologia de “Preserved Thinking” (Pensamento Preservado) permite que o sistema mantenha sua linha de raciocínio lógico ativa durante toda a interação.

Em cenários de agentes autônomos, onde a IA precisa realizar várias ações sequenciais, essa memória de trabalho garante que o objetivo inicial não se perca, eliminando a necessidade de reexplicar o contexto a cada nova interação.

Revolução no desenvolvimento de software e ‘Vibe Coding’ com o GLM 4.7

No campo da engenharia de software, a ferramenta demonstra uma competência muito acima da média.

O conceito de “Vibe Coding” introduzido com este lançamento foca na estética e na usabilidade do código gerado, especialmente para interfaces de usuário (front-end).

O sistema não apenas escreve código funcional, mas também se preocupa com o design visual, gerando páginas web e apresentações com layouts modernos e agradáveis.

A precisão em tarefas de terminal e automação também recebeu atenção especial.

Testes indicam que a capacidade de lidar com linhas de comando e scripts de automação supera modelos concorrentes, facilitando a vida de DevOps e engenheiros de sistemas.

A integração com ferramentas como Claude Code e ambientes de desenvolvimento populares é fluida, permitindo que a IA atue quase como um par programador sênior.

Benchmarks

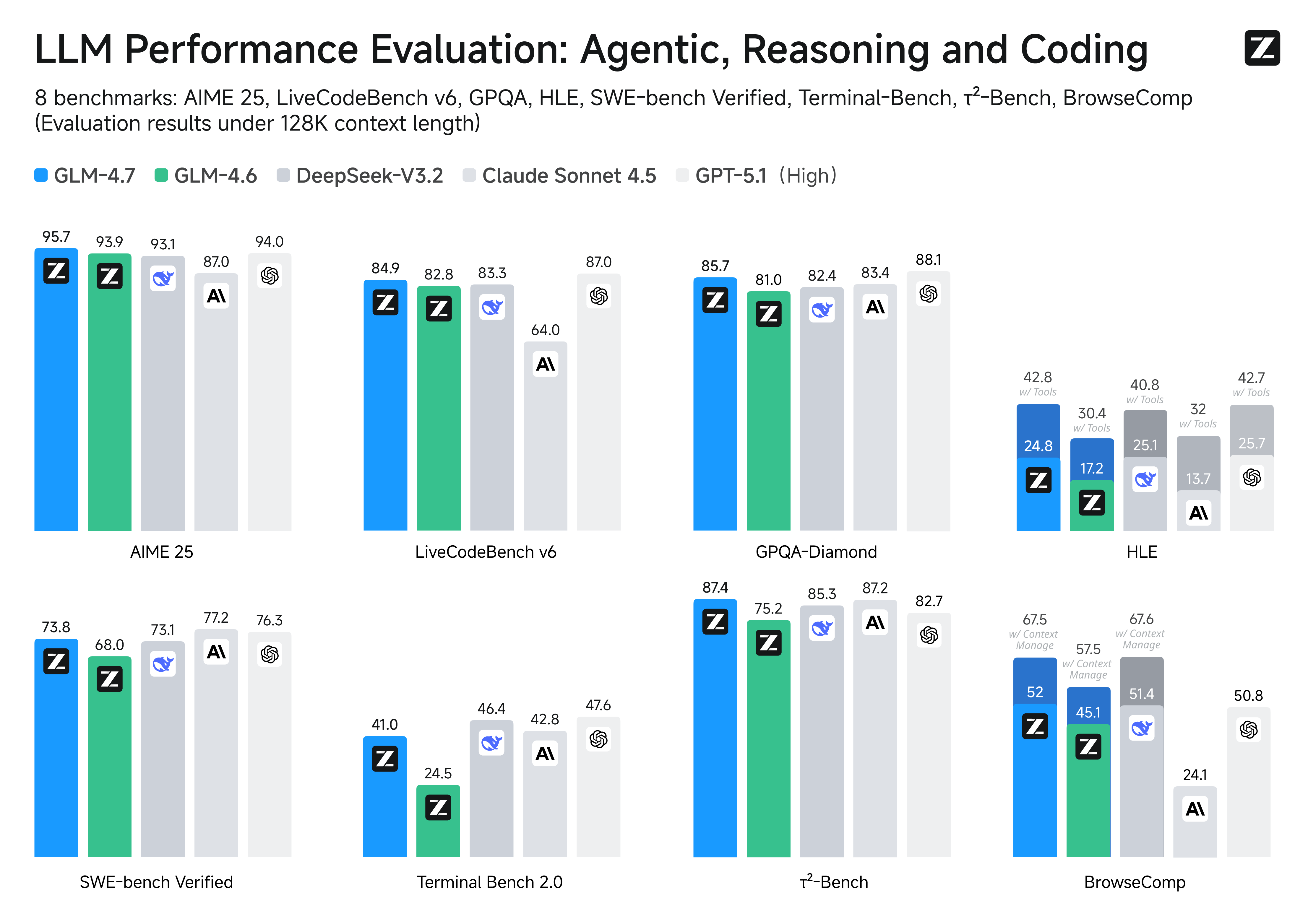

Os números comprovam a eficácia do GLM 4.7.

Em plataformas de avaliação como o SWE-bench, que mede a habilidade de resolver problemas reais de engenharia de software, o modelo obteve pontuações que o colocam no topo do ranking de código aberto.

Resultados preliminares mostram uma melhoria de dois dígitos em comparação com versões anteriores, consolidando sua posição de liderança.

Outro indicador relevante é o desempenho no “Humanity’s Last Exam” (HLE), um teste desenhado para ser extremamente difícil para IAs.

A pontuação alcançada demonstra uma capacidade de generalização e lógica abstrata que muitas vezes falta em modelos focados puramente em completar texto.

Assim, tais dados sugerem que a ferramenta está pronta para desafios que exigem criatividade e rigor técnico simultaneamente.

Comparativo direto: desempenho frente à concorrência global

Ao colocarmos o GLM 4.7 lado a lado com o GPT-5 (ou suas versões prévias de alto nível) e o Claude Sonnet, as diferenças tornam-se claras.

Enquanto alguns modelos focam excessivamente em segurança restritiva ou em criatividade literária, a solução da Zhipu AI equilibra pragmatismo com potência bruta.

Em tarefas de raciocínio matemático e lógica dedutiva, os testes mostram uma paridade técnica, e em alguns casos, uma leve vantagem para o modelo chinês.

Além disso, a relação custo-benefício também merece atenção.

Com um preço por milhão de tokens significativamente menor que seus rivais ocidentais, a barreira de entrada para empresas e desenvolvedores independentes diminui.

Isso democratiza o acesso a uma inteligência de ponta, permitindo que startups integrem capacidades avançadas de IA em seus produtos sem comprometer o orçamento operacional.

Integração com agentes e ferramentas externas

A habilidade de usar ferramentas externas (Tool Use) é outro ponto forte do GLM 4.7.

O sistema consegue navegar na web, executar código Python em ambientes isolados e interagir com APIs de forma autônoma com uma taxa de sucesso elevada.

Comparado ao Gemini ou ao GPT-5, a fluidez com que ele alterna entre geração de texto e ação prática é notável.

Essa competência é essencial para a criação de agentes autônomos que realizam trabalho real, como pesquisar dados de mercado, compilar relatórios e enviar e-mails, tudo sem intervenção humana constante.

A arquitetura foi otimizada para reduzir alucinações durante o uso de ferramentas, garantindo que as ações executadas sejam precisas e seguras.